先做个广告:需要购买Gemini帐号或代充值Gemini会员,请加微信:gptchongzhi

在2023年12月份,Google发布了Gemini系列大模型(参考:谷歌发布号称超过GPT-4V的大模型Gemini:4个版本,最大的Gemini的MMLU得分90.04,首次超过90的大模型:https://www.datalearner.com/blog/1051701914715663),包含3个不同参数规模的版本。其中,Gemini Ultra号称在MMLU评测上超过了GPT-4,并且在月初也将Bard更名为Gemini,开放了Gemini Ultra的付费使用。刚刚,Google的CEO劈柴哥宣布发布了Gemini 1.5 Pro,这意味着仅仅一个半月,Gemini有了重大更新。

推荐使用Gemini中文版,国内可直接访问:https://ai.gpt86.top

推荐使用Gemini中文版,国内可直接访问:https://ai.gpt86.top

Gemini 1.5简介

Gemini 1.5 Pro是MoE架构大模型

Gemini 1.5 Pro最高支持1000万上下文

Gemini 1.5 Pro的评测结果

Gemini 1.5 Pro的综合评测接近Gemini Ultra

Gemini 1.5 Pro总结

Gemini 1.5简介

本次发布的Gemini 1.5是Pro版本的更新,官方宣传Gemini 1.5 Pro的能力已经接近此前的Gemini Ultra 1.0的水平。按照此前发布的信息看,Gemini Pro的参数量应该是比Gemini Ultra低一个数量级。

Gemini 1.5 Pro是MoE架构大模型

Google说,Gemini 1.5 Pro是一个全新的MoE模型(Mixture of Experts,混合专家)。这意味着这是一个和Mixtral 7B×8类似架构的模型,也可能是大企业中首个公开宣称自己是MoE架构的模型了。这是一个中等大小的多模态模型,在各项任务评测结果都接近Gemini Ultra。

谷歌说,根据输入的类型,模型会决定最相关的专家网络来输出结果,但是除此之外,谷歌没有更多的信息透露,包括专家数量、模型参数等。

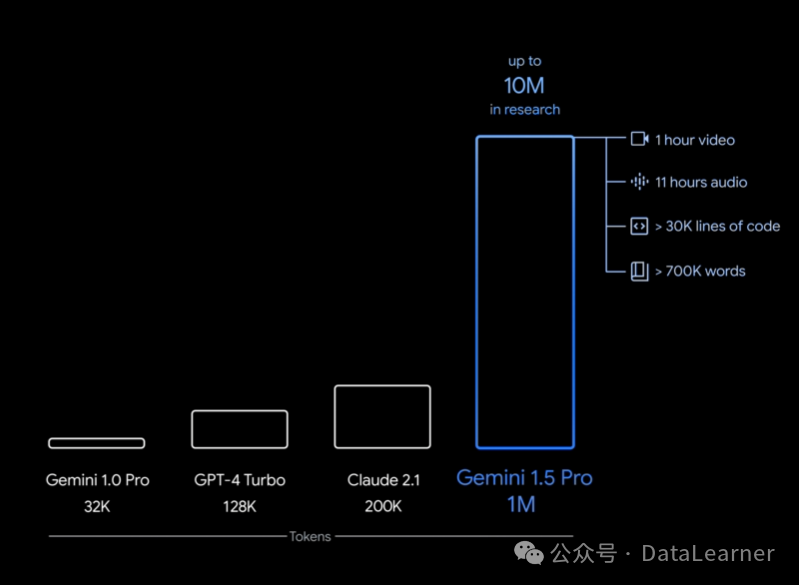

Gemini 1.5 Pro最高支持1000万上下文

同时在超长上下文方面有非常好的突破。此前,谷歌提供的Geminix系列最高支持128K超长上下文,与OpenAI目前提供的GPT模型的上下文长度一致,但是低于Claude 2.1的200K。而本次发布的Gemini 1.5 Pro最高支持100万tokens的上下文(目前仅仅面向有限的开发者和企业用户)!这应该是目前商用最长上下文的模型了!为了更好地支持100万上下文长度,谷歌说他们正在努力优化时延和计算需求。

什么概念呢?100万上下文意味着Gemini 1.5 Pro可以一次处理1个小时视频、11个小时音频、3万行代码或者70万单词!而这不是极限,谷歌说对于研究性质来说,最高可支持1000万tokens上下文!

Gemini 1.5 Pro的评测结果

谷歌在Gemini 1.5 Pro的技术报告中详细披露了Gemini 1.5 Pro的各项评测结果,其中有大量的在超长上下文和多模态的评测结果。在常规的测评中也表现很好。

Gemini 1.5 Pro的综合评测接近Gemini Ultra

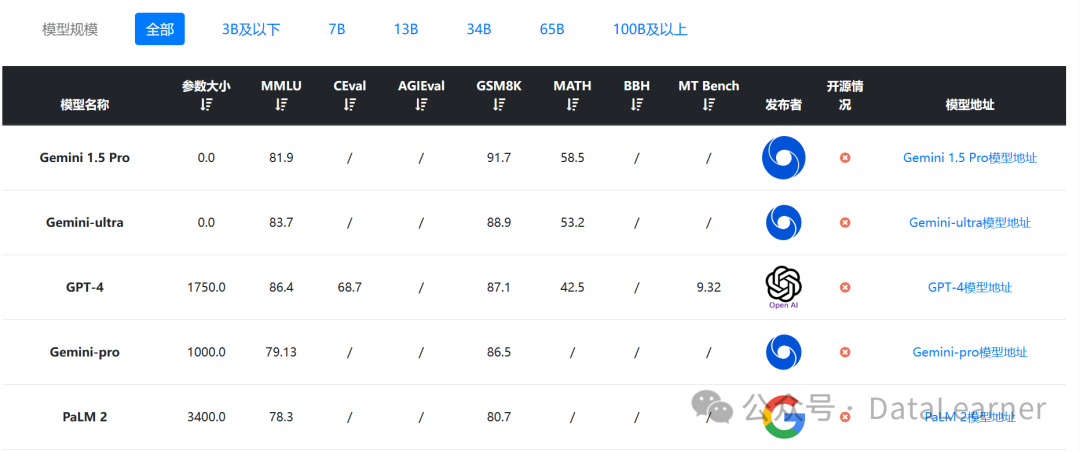

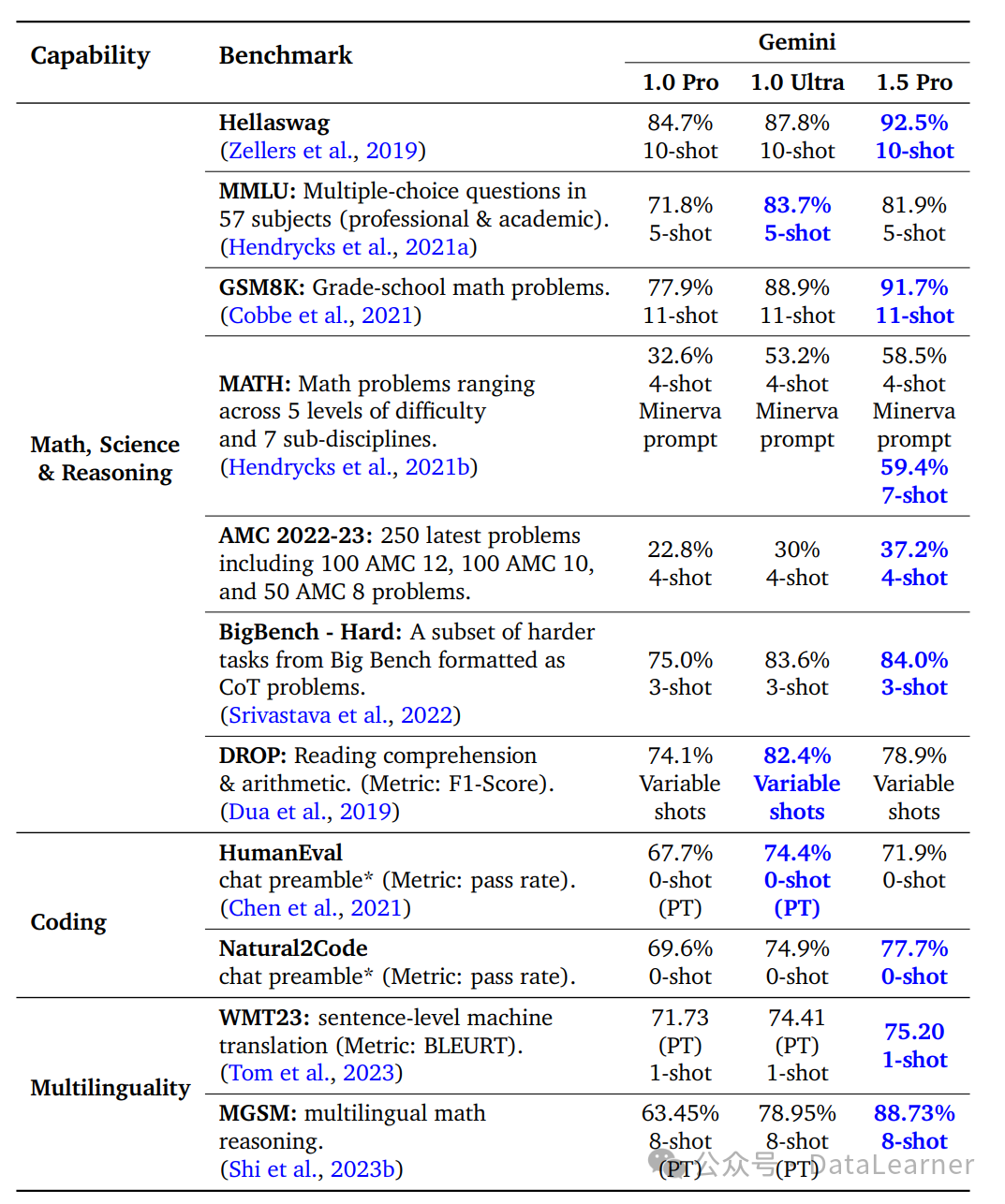

谷歌公布了Gemini 1.5 Pro在各项评测的分数,结果非常接近Gemini Ultra,同时部分评测结果超过原有模型。其中,GSM8K评测得分91.7,全球最高。

上图是DataLearnerAI大模型综合评测数据中按照GSM8K排序的结果,目前的Gemini 1.5 Pro排名第一,超过了Gemini Ultra 1.0和GPT-4,而MMLU的评测看Gemini 1.5 Pro也是非常接近Gemini Ultra 1.0,但是不如GPT-4,排名第三。具体更多的评测结果如下图:

此外,谷歌还公布了Gemini 1.5 Pro在多模态的评测结果,具体大家参考DataLearnerAI的模型信息卡即可:https://www.datalearner.com/ai-models/pretrained-models/Gemini-1_5-Pro

Gemini 1.5 Pro总结

谷歌官方在介绍Gemini 1.5 Pro的时候非常强调它的超长上下文和多模态能力,它可以直接从402页的阿波罗登月记录中推断对话、事件和其中的细节,展现了非常强大的推理能力和超长上下文的理解能力。

不过,目前Gemini 1.5 Pro仅提供给部分开发者和企业用户使用,而且目前仅能使用128K上下文版本。谷歌说很快就可以发布100万上下文测试版本。而且在早期测试中,测试者甚至是可以免费测试100万上下文的结果。